過去幾年,AI硬體產業幾乎可說是NVIDIA一個人的武林,即便競爭對手全力追趕,也難以組織起有效的攻勢,突破NVIDIA的嚴密防守。不過,2026年產業狀況可能會不太一樣。雖然NVIDIA仍將繼續擁有巨大的領先優勢,但急起直追的開放陣營業者,有機會給NVIDIA一點真正的壓力。

一面倒的球賽很無聊,有來有回才精彩。過去兩、三年,生成式AI硬體產業就是一場很無聊的球賽。由於市場領導者NVIDIA在運算效能、網路連接與開發者生態系這三個方面的領先優勢過於絕對,不管是大模型開發商或雲端服務供應商(CSP),除了採用NVIDIA提供的全套解決方案,幾乎沒有其他選擇。

不過,隨著多家晶片業者集結在開放陣營的大旗下,加上CSP業者策略性地培養第二供應商,作為牽制NVIDIA的槓桿,這些一度被戲稱為「NVIDIA反抗軍」的晶片業者,得到了持續提升自身技術與組建生態系所需的資源與空間。2026年將會是這些開放陣營的晶片業者,端出第一道大菜的時刻。

高速互連為基本要求 UEC/UALink聯袂上陣

由於AI模型訓練與向大量使用者提供推論服務,都對運算硬體的效能有著極高要求,因此,能用來執行模型訓練跟大型推論服務的硬體設備,本質上都是分散式運算系統。尤其是在分散式推論日益盛行,讓訓練與推論所需的硬體設備越來越相似的情況下,即便是只負責運行推論服務的叢集,其對網路跟互連的需求,也正在快速貼近訓練叢集。

也因為在雲端資料中心裡,AI運算必然是分散式運算。水平擴展(Scale-out)網路性能的好壞、可擴展性以及可靠度,會對整個運算叢集的運算效能、可用度與整體持有成本(TCO),造成決定性影響。NVIDIA採用的Infiniband技術並不新,而且成本高昂。但在生成式AI興起前,由於只有超級電腦才需要這種專為運算叢集設計的互連技術,因此業界沒有足夠的經濟誘因去投入技術更新,直到生成式AI成為眾所周知的金礦後,才吸引各路淘金者搶進,促成Ultra Ethernet Consortium(UEC)技術問世。

在垂直擴展(Scale-up)方面,情況也是類似。在生成式AI興起前,需要將多顆GPU串連成一顆虛擬GPU,實現超大規模平行運算的應用場景十分有限,因此在生成式AI興起後,業界才突然發現,PCIe的頻寬已經落後NVLink太遠,無法以滿足資料中心等級的多GPU互連需求,傳統乙太網通訊協定的設計也不太適合用來做GPU互連,只好趕快另起爐灶,發展Ultra Accelerator Link(UA Link)技術。

有業界人士評論稱,NVIDIA押對寶,而且是運算、網路跟軟體三個領域都押對了,所以過去這段時間,生成式AI才會變成NVIDIA一個人的武林。這是NVIDIA承擔風險所應得的回報。開放陣營必須等到UEC、UA Link標準底定並商品化之後,才算是與NVIDIA站在同一個量級的擂台上較量。當然,能站上擂台是一回事;能不能擊敗拳王,又是另一回事。

Helios補足機櫃產品布局

除了UEC、UA Link技術商品化之外,在NVIDIA已經完成從晶片到機櫃的完整布局的今天,開放陣營若要與之對壘,在機櫃領域也不能缺席。而這個重責大任,則被寄託在同樣擁有GPU技術的超微(AMD)身上。

為了建構自身的伺服器系統設計能力,超微在2024年8月宣布購併ZT Systems,並在購併完成後短短兩個月,就將ZT Systems的伺服器製造業務賣給EMS業者Sanmina,以避免與伺服器製造商、品牌客戶發生業務衝突。預定於2026年推出的Helios(圖1),就是這件購併案的成果展示。

圖1 超微將於2026年推出的Helios機櫃方案

圖1 超微將於2026年推出的Helios機櫃方案

根據超微執行長蘇姿丰在Advancing AI 2025活動上所發表的資訊,Helios將搭載開發代號Venice,採用Zen 6架構的EPYC CPU、採用CDNA 4架構的MI400 GPU加速器,以及吞吐量可達800G,並支援UA Link的下一代網路處理器Vulcano。Helios將全面搭載超微最新一代架構的晶片產品,而不是在既有架構上升級的晶片方案,因此業界與超微自身,都對Helios的整體性能表現具有高度期待。

Helios機架可容納72顆GPU並透過開放標準UA Link互連,讓全機架GPU溝通如同統一系統。同時,每顆GPU對外的網路介面經由新一代Pensando Vulcano AI NIC擴充,可支援800Gb/s傳輸,以及相當於前代產品8倍的水平擴充頻寬。其定位是一個像單一巨大運算引擎的整櫃系統,為客戶提供可與NVIDIA DGX POD等抗衡,但更加開放靈活的選項。

不過,為了維持對開放生態系的承諾,超微強調其採用A+A+A(按:CPU、GPU與網路處理器採用AMD方案)的機櫃方案將完全基於產業開放標準,不會有供應商鎖定的情況。且Helios的外觀尺寸符合OCP規範,因此CSP客戶可以很輕鬆地將Helios整合進自家的資料中心。

開放陣營軟體問題仍待解

2026年被視為轉折點,正因上述開放生態重要產品與技術標準將密集進入市場,開放陣營終於有機會藉此在AI基礎設施版圖上,組織起一波真正有效的攻勢,而非零散的反擊。然而,困擾開放陣營的軟體老問題,恐怕還是無法完全解決。

許多人認為,除了完整的硬體產品組合外,CUDA是NVIDIA最難以攻破的護城河。但這樣的觀點能不能成立,得看客戶群是誰。如果是擁有龐大軟體開發團隊的CSP或大型軟體公司,對他們而言,CUDA其實不是太致命的問題,否則微軟、Meta也不會導入超微的GPU加速器。而且,擁有大量採購訂單的CSP,自然是超微的軟體工程團隊必須重點服務的客戶。

但如果是一般企業用戶或小型開發者,CUDA確實就是一道相當難以跨越的護城河。由於這類客群沒有自己解決應用移植問題的能力,超微的工程資源也較難照顧到這些客群,因此企業與小型開發者,會比CSP或大型軟體公司,更容易被綁在NVIDIA的生態系統中。NVIDIA顯然也知道這點,因此過去一年多來,該公司一直在強力推廣自家的NIM方案,希望把企業客戶抓得更牢固。

對此,超微的應對方式是推出開發者雲端服務(Developer Cloud),並持續強化自家的ROCm軟體,一方面提升性能,另一方面則是擴大其支援範圍。

開發者雲端服務是一個提供給開發者測試超微GPU加速平台的有條件免費服務。開發者可以透過Github帳號註冊該服務,並獲得一定額度的免費使用時間,以測試應用在超微平台上執行的效果。同時,超微也開始結合開源生態系的力量,打造出針對企業需求設計的應用。

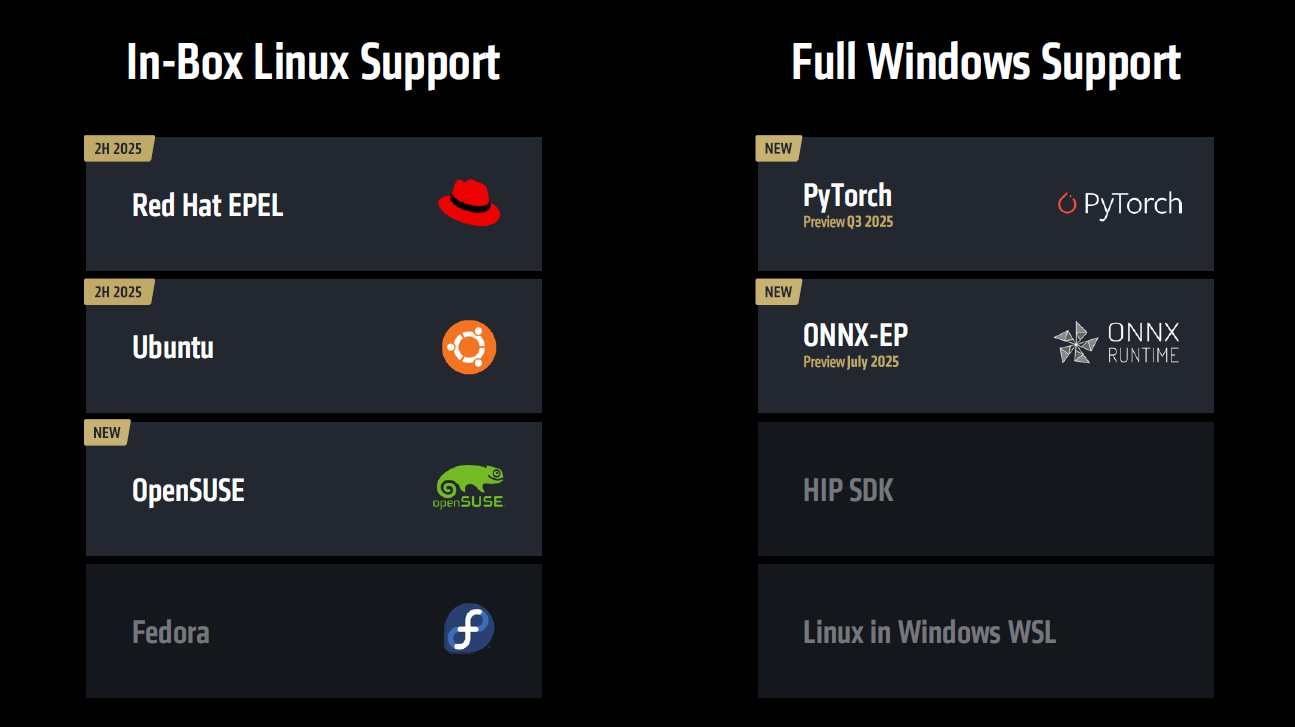

至於在ROCm方面,在最新版的ROCm 7中,超微也對Llama 3.1、Qwen2、DeepSeek R1等主流開源模型,提供更好的支援,使其透過ROCm 7訓練、推論的效能,提升至ROCm 6的3倍以上。同時,在邊緣/用戶端應用場景,ROCm 7的支援範圍也明顯擴大不少,像PyTorch、ONNX-EP的Winodws版本,原本都沒有完整支援ROCm,但從2025年第三季開始,這兩個重要框架的Windows版本,都將完整支援ROCm 7(圖2)。

圖2 ROCm 7將獲得更多軟體框架與作業系統的全面支援

圖2 ROCm 7將獲得更多軟體框架與作業系統的全面支援

整體而言,超微針對開發者提供的軟體方案陣容,在2025年也有明顯進展。但由於開發者普遍有比較強的慣性,因此在開發者經營方面,超微肯定要做好長期抗戰的準備。

AI硬體不再是一個人的武林 NVIDIA仍有餘裕

展望2026年的AI硬體市場,儘管NVIDIA仍將大幅領先,但整個市場不會再是NVIDIA一個人的武林。因此,NVIDIA本身也在調整策略,試圖以更靈活的作法來鞏固其對整個AI產業的影響力。

2025年COMPUTEX期間,NVIDIA發布了NVLink Fusion計劃,允許產業夥伴將自家ASIC/CPU透過NVLink與NVIDIA GPU緊密耦合,打造半客製化的AI硬體。就是一個很好的案例。包括聯發科、Marvell等多家公司都宣布加入NVLink Fusion生態,與NVIDIA合作開發客製晶片。這意味著NVIDIA也意識到,將手上某些籌碼釋放出去,爭取友軍支持的必要性;另一方面,透過NVLink Fusion,也能確保這些新晶片仍在NVIDIA的主導下,從而在開放浪潮中維持公司的核心地位。

但是,其他競爭對手的追趕步伐,會在2026年明顯加快。超微作為GPU領域的主要挑戰者,在過去兩年已憑藉MI300/MI350系列在2024~2025年逐步站穩腳跟,並打算在2026年以MI400及Helios機櫃,加上UEC、UA Link技術的到位,組織起一波更有威脅性的反擊。儘管NVIDIA的寶座難以撼動,AMD至少可望在雲端服務商客群,爭取到比以往更大的市占率。畢竟,如果有得選,客戶也不會想把雞蛋都放在同一個籃子裡。